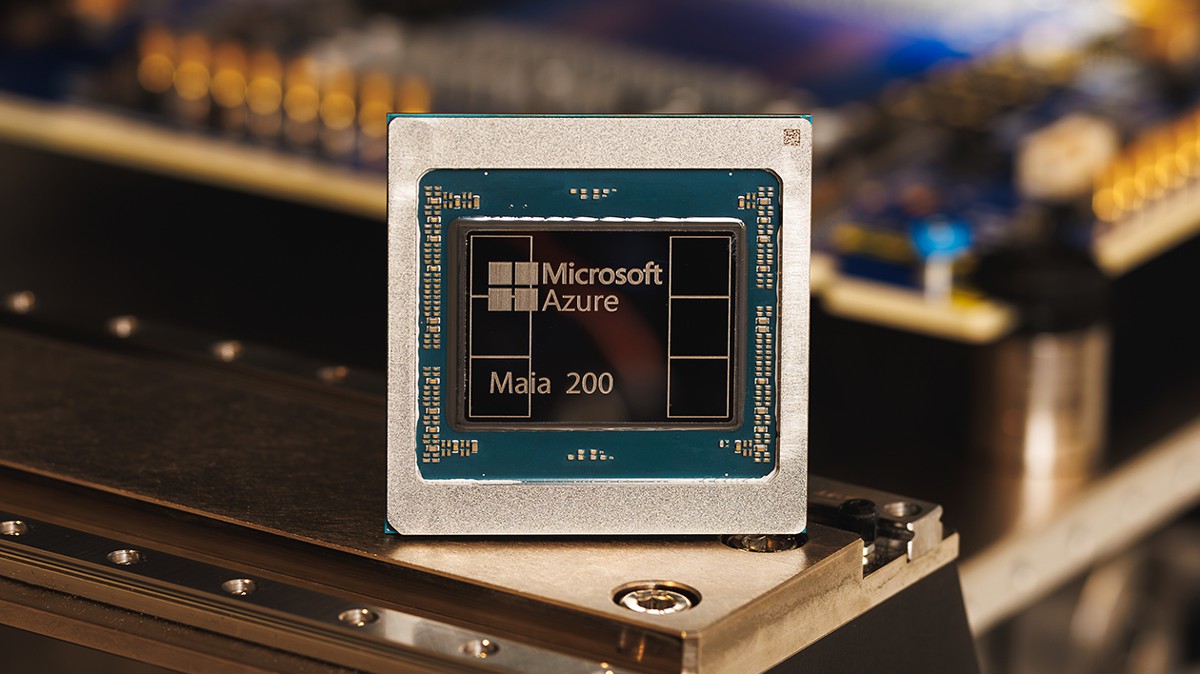

微軟今日正式發布了專為 AI 推理設計的新一代自研晶片 Maia 200。這顆採用台積電 3 奈米製程的運算核心,電晶體數量驚人地突破了 1,400 億個,專門用來處理那些讓資料中心電費噴發的「推理(Inference)」任務。微軟宣稱,Maia 200 的 FP4 算力是亞馬遜 Trainium 3 的三倍,效能甚至超越了 Google 第七代 TPU。更重要的是,它能讓每美元的運算效能提升 30%,這對於正在瘋狂運作 GPT-5.2 的微軟和 OpenAI 來說,無疑是續命的關鍵。

為了 GPT-5.2 而生:不只是算力,更是記憶體革命

Maia 200 最強悍的地方不在於它有 10 Petaflops 的 FP4 算力,而在於它解決了 AI 運算中最致命的「數據餵不飽」問題。它配備了高達 216GB 的 HBM3e 記憶體,頻寬達到驚人的 7 TB/s。這意味著即便像 GPT-5.2 這種等級的超大型模型,在 Maia 200 上跑起來也能「毫無壓力」。微軟甚至大方承認,自家的 Superintelligence 團隊早已開始用它來生成合成數據與進行強化學習, Copilot 的對話也早就靠它在後台撐腰。

脫離 Nvidia 依賴症:雲端巨頭的「矽盾」之戰

這不只是一次技術發表,更是一場政治宣告。隨著 Google 有 TPU、亞馬遜有 Trainium,微軟透過 Maia 200 補齊了最後一塊拼圖。藉由自研晶片,微軟可以大幅降低對 Nvidia 昂貴 GPU 的依賴。雖然微軟強調這是「異質基礎設施」的一環,但誰都看得出來,當 Maia 200 能以更低的功耗提供更高的代幣(Token)輸出時,Nvidia 的溢價空間正被無情地壓縮。

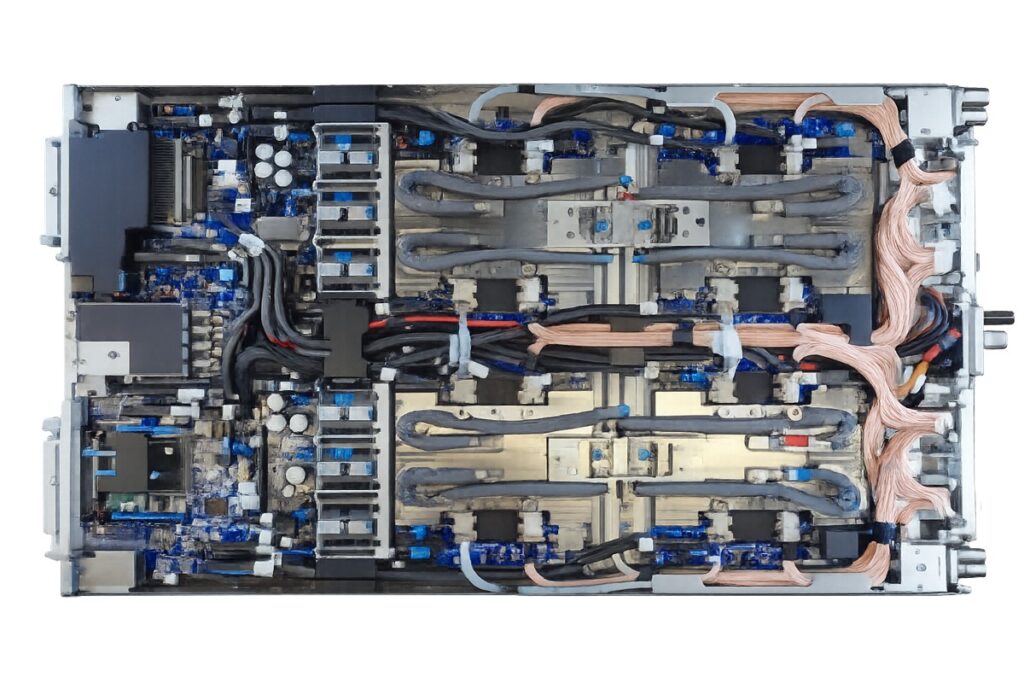

封閉循環水冷:Des Moines 資料中心的冰冷野心

為了鎮住這顆 TDP 高達 750W 的發熱怪獸,微軟同步推出了第二代封閉循環液冷熱交換單元。目前 Maia 200 已率先部署在愛荷華州 Des Moines 的資料中心,緊接著將前往亞利桑那州。微軟這次不僅賣晶片效能,還賣一整套 SDK 工具組,邀請開發者、新創公司與學術界直接透過 PyTorch 和 Triton 編譯器來壓榨這顆晶片的極限。

短評:說白了,微軟是在幫自己的「AI 帳單」瘦身

微軟這次的吃相相當專業。它沒有大喊大叫說要取代誰,但從它拿出「每美元效能提升 30%」這種數據時,它的手就已經伸進了黃仁勳的錢包裡。

對於微軟來說,Maia 200 就像是一台為了自家貨運生意(GPT-5.2)量身定制的省油卡車。既然家裡的貨車每天都要跑遍全球,與其每年花大錢去跟別人租超跑,不如自己造一台載貨量最大、油耗最低的工具車。這件事的邏輯很硬:當 AI 推理成本決定了一家科技公司的獲利能力時,把「印鈔機」的核心零件掌握在自己手裡,才是最極致的商業理性。

如果 2028 年那些光學晶片還沒做出來,微軟現在這手「矽基改良術」恐怕就是目前最能止血的財政手段了。