在多哈舉辦的 Web Summit 上,ElevenLabs 執行長 Staniszewski 發表了一番近乎「數位解放」的言論。他認為,人類被螢幕囚禁的時間太長了,而 語音介面 正是解藥。隨著 ElevenLabs 本週以 110 億美元的高估值完成 5 億美元融資,這家語音 AI 巨頭正正式向螢幕宣戰。他們的目標不再只是「模仿人類說話」,而是要讓語音模型與 LLM 的推理能力深度結合,讓 AI 成為一個能聽懂情緒、具備長期記憶,且隨時待命的「隱形管家」。

為什麼「出一張嘴」比「動手指」值錢?

這次 Web Summit 的對談揭示了 2026 年 AI 發展的幾個核心轉向:

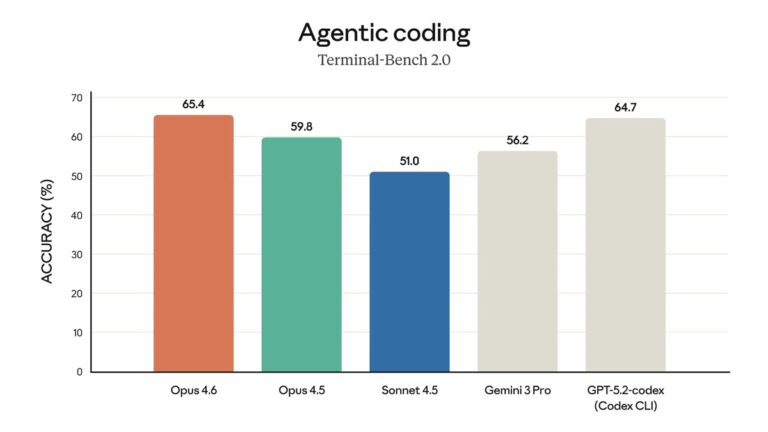

- 從「錄音機」進化為「特工」: 以前的語音 AI 只是把文字唸出來。現在的 語音介面 開始具備「主動性(Agentic)」。它不再需要你下達精確指令,而是能根據長期累積的上下文記憶,猜測你現在想幹嘛。

- 混合運算架構: 為了讓反應速度像真人一樣快,ElevenLabs 正在開發「雲端+裝置」的混合模式。這意味著即使在沒網路的深山,你的智慧耳機依然能陪你聊天。

- 硬體大集結: 除了 OpenAI 和 Google 瘋狂投入語音戰場,Apple 也被爆出正透過收購 Q.ai 秘密打造「永遠在線」的語音技術。ElevenLabs 則已經抱上 Meta 的大腿,準備進入 Instagram 和 Horizon Worlds,甚至連那副 Ray-Ban 智慧眼鏡都在他們的射程範圍內。

以後在街上自言自語,可能不是瘋子,是在「工作」

Staniszewski 描繪的未來很美好:手機放口袋,我們重新擁抱現實世界。但身為一個務實的 AI 觀察家,我不得不吐個槽:

- 隱私是什麼?能吃嗎? 當 AI 變成「常駐伴侶」,意味著它必須 24 小時聽著你生活中的一舉一動(包括你在廁所裡的沉思)。Google 之前才因為這類問題被噴得體無完膚,ElevenLabs 真的能讓大家放心交出耳朵嗎?

- 公共場所的災難: 想像一下 2026 年的捷運車廂,不再是安靜的低頭族,而是幾百個人同時對著空氣說:「嘿,幫我訂這家餐廳」、「幫我寫這封辭職信」。欸…抱歉!我不是在跟你講話…。

- 語音的「傲嬌」: 雖然執行長說現在 AI 能聽懂情緒,但萬一哪天你只是口氣差了一點,AI 特工就決定「罷工」或「已讀不回」,那這段「人機關係」可能比婆媳問題還難搞。

不過說真的,看著傳統鍵盤被矽谷大佬們形容為「過時(Outdated)」,我彷彿聽見了那些還在苦練打字的人心碎的聲音。